Источник: ITC.ua

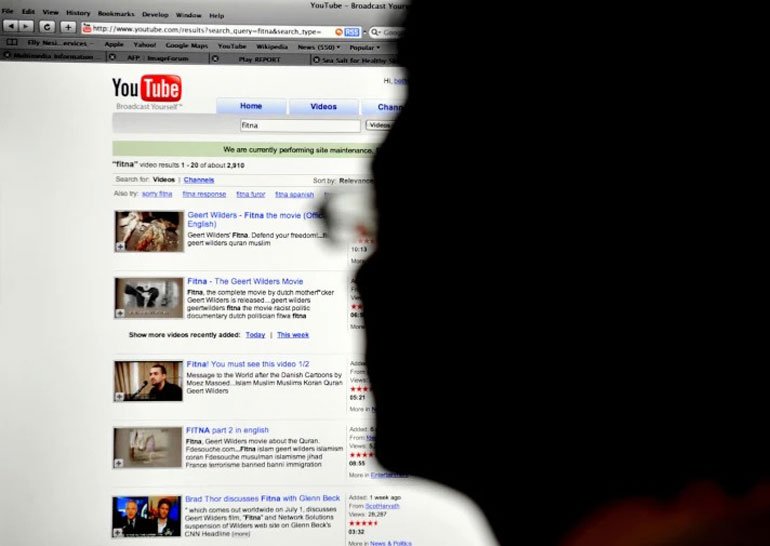

Сервис YouTube активно использует автоматические алгоритмы и команду людей-модераторов для предотвращения появления на платформе контента, пагубно влияющего на детей.

Но борьба с подобным видео пока осуществляется недостаточно эффективно.

Тому есть несколько причин. И одной из них является наличие запутанного набора рекомендаций, который модераторы получают от компании для оценки контента.

Действия этих экспертов в дальнейшем используются для обучения поисковых алгоритмов искусственного интеллекта, ранжирующих видео в поиске на платформе YouTube.

Как оказалось, этим сотрудникам давались инструкции присваивать роликам высокий рейтинг в основном, на основании оценки их производственной ценности, даже если содержание вызывает обеспокоенность.

Один из таких сотрудников рассказал, что если видео является неподобающим и содержит сцены насилия, то модераторы должны его помечать соответствующим образом, но также фиксировать факт высокого качества ролика.

А отметка «высокого качества» способствует хорошему ранжированию видео и появлению на верхних позициях поисковой выдачи.

Проблема заключается в том, что потенциально опасные для детей ролики обычно имеют высокую производственную ценность – для их создания требуется приложить определённые усилия, затратить время и ресурсы на монтаж.

Несколько месяцев назад разразился скандал, и сервис YouTube был обвинён в распространении опасного для детей контента.

В результате, многие крупные рекламодатели отказались от дальнейшего размещения рекламы на платформе YouTube.

После этого сервис обратился к модераторам с просьбой определять, подходят ли ролики для просмотра детьми в возрасте 9-12 лет без присмотра со стороны взрослых.

Эксперты должны выявлять и отмечать как неподобающий для детей контент, содержащий наготу, сексуальные действия и их имитацию, сцены насилия, нецензурную лексику, использование медикаментов и наркотиков, жестокие розыгрыши и другие примеры плохого поведения.

Но при этом администрация предоставила сбивающие с толку примеры. Например, учитывая рекомендации платформы, видеоклип Taylor Swift Bad Blood является неприемлемым.

А ролик, включающий незначительные сцены насилия над животными – является вполне допустимым.

Профессор по вопросам искусственного интеллекта Корнеллского университета Барт Селман назвал это примером «несовпадения стоимости».

Это несоответствие ценности с точки зрения доходов компании и общего блага для широких слоём общества.

Для платформы наиболее ценным является контент, генерирующий активность, много просмотров, показов рекламы и рост доходов.

Зачастую, это спорный и экстремальный контент. Но для общества в целом такие ролики могут быть неприемлемыми, особенно для детской аудитории.

Распространением спорных инструкций, которые ещё больше запутывают модераторов, а затем и обучаемые на их действиях алгоритмы ИИ, YouTube лишь усугубляет ситуацию.

В результате, с платформы может удаляться вовсе не те ролики, которые действительно опасны для детей.

Для очистки платформы от неподобающего контента администрация YouTube намерена привлечь 10 тыс. новых модераторов.

Но для их эффективной работы необходимо выработать более конкретный набор руководящих принципов и сделать ранжирование менее запутанным для своих сотрудников.

Самые актуальные новости - в

Самые актуальные новости - в