Программное обеспечение, которое должно быть беспристрастным, унаследовало вредные человеческие стереотипы.

Ученые из Калифорнийского университета в Беркли совместно с коллегами из Чикаго выяснили, что компьютерные алгоритмы, созданные для исключения предвзятости при оказании медицинской помощи, вместо этого демонстрируют расовые предпочтения. Свою работу авторы опубликовали в Science.

Исследователи проанализировали, как алгоритмы отбирают пациентов для попадания в госпрограмму медицинской поддержки. Предполагается, что это программное обеспечение поможет выделить пациентов с высоким риском здоровью, не руководствуясь человеческими стереотипами, предубеждениями, предрассудками или склонностями. Важно, чтобы нуждающийся в лечении пациент не получал по решению сотрудника отказ из-за «неправильного» пола, расы, образования, религии или образа жизни.

Однако, как показывают работы последнего времени и, в частности, исследование авторов, алгоритмы активно набирают в качестве критериев отбора предубеждения, свойственные людям. Почему так получается? Иногда проблема в подходе к обучению, если речь идет о нейросетях. В случае же, описанном в статье, проблема была в недостатке переменных, которыми оперировала программа.

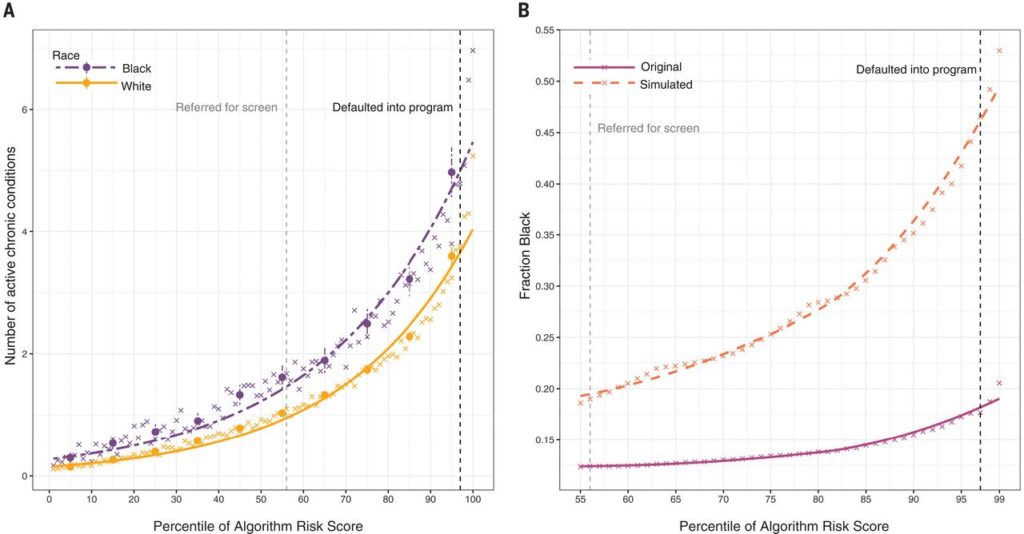

Ученые рассмотрели данные 43 539 белых пациентов и 6079 чернокожих, которых алгоритм должен был либо поместить в группу людей, которым требуется помощь, либо отказать в ней. Задача перед программой стояла такая: выбрать тех пациентов, кому можно помочь с наибольшей эффективностью соотношения «риск — результат — затраты». Выбор, сделанный компьютером, сравнили с объективными показаниями (учитывающими биомаркеры и жизненные показатели), сделанными вручную без учета расы пациента. Оказалось, при отборе программа показала расовую предвзятость, предпочитая здоровых белых американцев и обходя чернокожих пациентов.

Исследователи выяснили, что перекос возник из-за ошибки при построении алгоритма отбора. Чернокожее население при современном состоянии здравоохранения в США хуже обеспечивалось медпомощью и, как следствие, в среднем имеет худшее состояние здоровья. В результате, учитывая сопутствующие заболевания и зачастую большую запущенность основных недугов, раса в алгоритмах программы становится сцепленной с худшими прогнозами и большей стоимостью лечения.

«Сами по себе алгоритмы не являются ни хорошими, ни плохими. Это просто вопрос заботы о том, как они построены. В этом случае проблема в высшей степени решаема, и по крайней мере один производитель [программного обеспечения], кажется, работает над исправлением. Мы призываем других сделать это», — поясняет автор работы профессор Сендхил Малленатан. Внеся в алгоритмы больше переменных — например, учитывающих снижение последующих затрат на лечение за счет небольших расходов на профилактику, — ученые получили нормальное расовое распределение пациентов, прошедших отбор.

По словам исследователей, это показывает, что важно учитывать все факторы при принятии решений, чтобы не получать нежизнеспособные методы оценки. Необходимы регулярные проверки, которые помогут устранять ошибки в вычислениях. «Для алгоритмов, как и для медицины, мы бы предпочли предотвращать проблемы, а не лечить их», — шутит ведущий автор работы Зиад Обермейер.

Источник: Naked Science

Самые актуальные новости - в

Самые актуальные новости - в